更强感知和定位能力!极智嘉联合卡耐基梅隆大学提出全新提取对象描述符算法

近日,全球AMR引领者极智嘉(Geek+)联合卡耐基梅隆大学(CMU)提出了的全新提取对象描述符算法,并成功在著名机器人期刊IEEE Robotics and Automation Letters(RA-L)上发表,充分印证了极智嘉在移动机器人视觉感知和V-SLAM定位导航方面的创新能力与技术实力备受学术权威的认可!

IEEE Robotics and Automation Letters (RA-L)是机器人领域的知名短文顶刊,属JCR一区期刊,在Google h5-index上机器人领域综合排名第二,期刊排名第一,享有较高知名度和权威性。

全新提取对象描述符算法

大幅提升感知和定位能力

对象描述和匹配对机器人的视觉感知及V-SLAM定位有着重要作用。尤其是在语义SLAM方面,对象匹配既有助于前后帧相对位姿的计算,也可以辅助更加准确的检测回环,从而建立高精度的地图。为此,极智嘉提出全新的提取对象描述符算法,同时利用卷积神经网络(CNN)和图神经网络(GNN)来编码对象携带的信息,可用于对象的匹配和视觉重定位,大幅提升视觉地图的精度和重定位的准确率,强化机器人感知和定位能力,在完成更复杂的业务任务的同时减少错误概率。

极智嘉订单到人拣选机器人A60C采用激光SLAM+视觉SLAM导航技术运行在人机混合的复杂场景中,需要非常准确的定位和对象识别能力。本文提出的全新提取对象描述符算法既提升了A60C机器人的对象感知能力,也提高了该款机器人V-SLAM定位的准确率,使其满足几乎所有工业、仓库场景实时变化的需求,并且确保人机混行的安全性。

算法成果详解

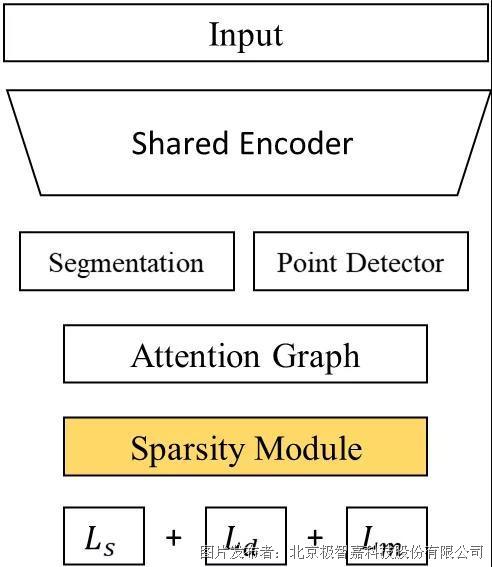

算法的流程如图1左所示。首先,利用卷积网络提取图像的特征图,并用一个语义分割的Header和一个特征点提取的Header获取这张图像上的对象掩膜和对象上对应的特征点。然后利用注意力机制将对象上离散的特征点形成一个加权无向图,并用图网络处理这个加权无向图。最后,用一个特征稀疏模块将多个低维特征聚合成一个高维的对象描述符。

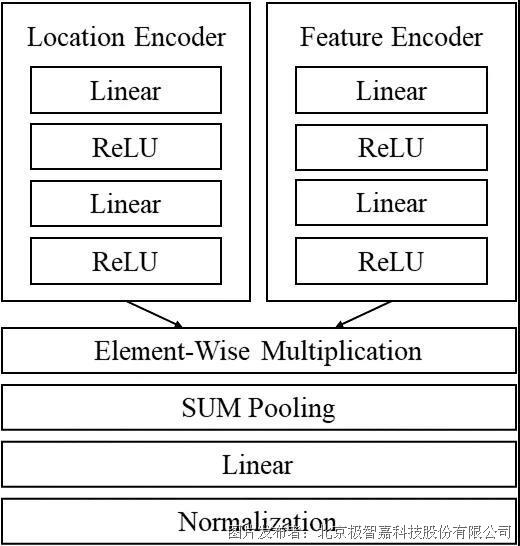

图1.算法流程(左)和特征稀疏模块流程(右)

为了解决不同视角下同一对象上特征点数量差异造成对象匹配困难的问题,极智嘉在文中提出了一种特征稀疏聚合的算法。如图1右所示,两个网络分支可以同时学习特征点内容信息和特征点所占据对象描述符的位置信息,其结果按元素相乘聚合后再进行二范数归一化。

网络训练的损失函数包含三部分:稀疏化损失函数——使聚合前特征点变得更稀疏以降低单个特征点对对象描述符的影响,稠密化损失函数——使最终的对象描述符更加稠密以增加描述符的空间利用率,和匹配损失函数——降低不同图像上同一对象描述符的距离,同时增加不同对象描述符的距离。

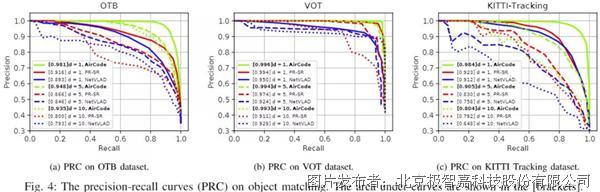

新算法在OTB,VOT和KITTI数据集上取得了优异的对象匹配和重定位效果,实验结果表明其性能超越了著名的特征聚合算法NetVLAD以及对象匹配算法PR-SR。

图2.对象匹配实验结果

图3.KITTI Odometry数据集上重定位效果

论文链接:https://arxiv.org/pdf/2105.00327.pdf

工程代码:https://github.com/wang-chen/AirCode