应对人工智能数据中心的电力挑战

供稿:工控网

国际能源署(IEA)的数据表明,2022 年数据中心的耗电量约占全球总用电量的 2%,达到 460 TWh 左右。如今,加密货币和人工智能/机器学习 (AI/ML) 等高耗能应用方兴未艾,而这些技术中通常需要部署大量的高性能图形处理单元 (GPU)。因此,数据中心耗电量仍将不断攀升。

人工智能应用的扩展速度令人震惊。ChatGPT 上线仅 5 天,用户数量就达到了 100 万,并在 2 个月内突破了 1 亿,这一增长速度远超于 TikTok 和 Instagram。GPT-4 训练包含超过 1.7 万亿参数和 13 万亿 token,总共使用了 2.5 万个 NVIDIA A100 GPU,每台服务器的功耗约为 6.5 kW。据 OpenAI 称,GPT-4 的训练耗时 100 天,消耗能源约 50 GWh,耗资 1 亿美元。

在当前环境中,我们很难准确估计未来耗电情况,其中为支持人工智能而部署的GPU 消耗了大部分电力。国际能源署保守预测,到 2026 年,数据中心的耗电量将至少达到 650 TWh,甚至可能超过 1,000 TWh。

人工智能数据中心的架构演变

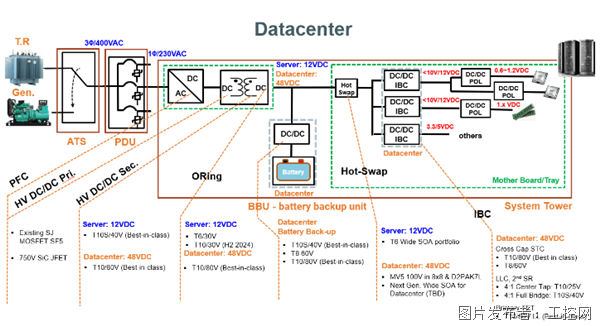

早期数据中心将电网电压集中转换为12V,然后通过总线将电力传输至服务器,再通过逻辑电平转换器将电压转换为 3.3/5V。然而功率需求不断提升,这种供电方法的电能损耗变得不可接受。因此,母线电压被提高到 48V,电流减小到原来的 1/4,损耗降低到了原来的 1/16。

而目前处理器电压进一步降低,从3.3V 降到了低于 1V 的亚伏特级别,此时就需要使用多条功率相对较高的电压轨。这进而催生了两级电压转换方案。该方案使用 DC-DC 转换器作为中间总线转换器 (IBC),先将 48V 电压转换为 12V 的局部总线电压,然后再将此转换为所需的低电压。

图1:典型服务器电源架构 – 中间总线

人工智能数据中心需要高能效电源转换

功率损耗带来了双重挑战,不仅会造成能源浪费、增加运营成本,而且会产生大量热量,进而需占用更大空间、消耗更多成本。运营超大规模人工智能数据中心时,机架功率需求为120 kW。将电网电力转换为 GPU 所用电压的能效约为 88%,这意味着会产生大约 15 kW 废热,并需要通过液冷技术进行有效散热。

在服务器电源设计中,能效和功率密度是两个重要概念,二者相辅相成。我们必须尽可能高效地将来自电网的能量转换为有用功率,减少损耗。为此,电源拓扑不断演变,业界开发了同步整流等技术,并在整流器中采用MOSFET 取代了损耗较大的二极管。

改进拓扑结构只成功了一半。为了优化能效,还必须尽可能提高所有元器件的能效,尤其是对转换过程至关重要的MOSFET。

MOSFET 并非无损耗器件,在导通和开关过程中也会产生损耗。随着服务器电源不断提高运行频率以缩小尺寸,开关损耗成为了优化的重点。

高效PowerTrench® MOSFET

安森美(onsemi)的中低压T10 PowerTrench®MOSFET采用了新型屏蔽栅极沟槽技术,降低了开关损耗和导通损耗,并进而显著降低了其Qg,RDS(ON) 也降至 1mOhm 以下。其中的先进软恢复体二极管缓解了振铃、过冲和噪声问题,同时降低了 Qrr 损耗,为快速开关应用找到了性能与恢复时间的平衡点。

与早期器件相比,这些新型MOSFET 可使开关损耗降低高达 50%,并使导通损耗降低 30% 以上。

图2:PowerTrench® T10 MOSFET 的优势

安森美新型40V和80V T10 PowerTrench 器件的RDS(on) 表现出色。NTMFWS1D5N08X(80 V、1.43 mΩ、5 mm x 6 mm SO8-FL 封装)和NTTFSSCH1D3N04XL(40 V、1.3 mΩ、3.3 mm x 3.3 mm 源极向下双散热封装)具有优异的品质因数(FOM),是人工智能数据中心电源供应器(PSU) 和中间总线转换器应用的理想选择。T10 PowerTrenchMOSFET 符合严格的 Open Rack V3 能效标准,即能效达到 97.5% 以上。