RK3588实现Deepseek-R1 1.5B模型本地部署,Token实测10.22/s!

- 关键词:Deepseek-R1 1.5B,RK3588,Token实测

- 摘要:RK3588实现Deepseek-R1 1.5B模型本地部署,Token实测10.22/s,维准电子基于瑞芯微RK3588国产化平台对DeepSeek-R1 1.5B的蒸馏模型进行了适配和部署,采用RKLLM Tookit工具实现了NPU平台对语言模型的加速与量化,为能源电力、智能制造、智慧医疗、AI边缘计算等工业应用赋能。

1. 前言

DeepSeek-R1的免费开源使得AI模型需求爆增,各大云平台都在积极接入Deepseek-R1,亚马逊Amazon和微软Azure甚至在Deepseek-R1开源后的一周内实现接入,目前国内已有几百家平台部署或接入Deepseek。

维准电子基于瑞芯微RK3588国产化平台对DeepSeek-R1 1.5B的蒸馏模型进行了适配和部署,采用RKLLM Tookit工具实现了NPU平台对语言模型的加速与量化,为能源电力、智能制造、智慧医疗、AI边缘计算等工业应用赋能。

作为英伟达官方认可的国产大模型,DeepSeek-R1 以零复杂提示技术降低使用门槛,用户仅需明确任务目标即可获得专业级文本生成与语义理解服务,同时其 API 价格仅为行业标杆的 1/10,推动 AI 普惠化。目前,三大运营商已全面接入该模型,结合专属算力方案,赋能金融、通信、教育等多领域智能化升级。尽管专注于文本领域,其开源生态与高效推理能力仍被国际视为AI 竞争的新标杆,彰显国家在大语言模型赛道的技术突破。

2. Deepseek-R1模型简介

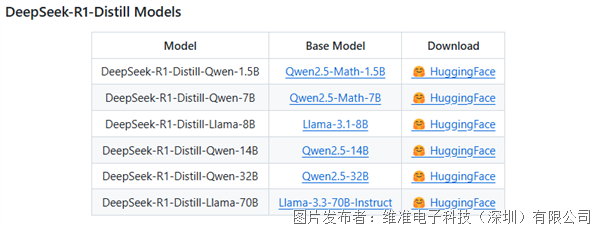

DeepSeek-R1 是由深度求索(DeepSeek)推出的开源大语言模型,以强化学习驱动的高效推理能力为核心,重新定义复杂任务处理范式。通过独创的 GRPO 强化学习算法实现自我优化,无需依赖监督数据即可在数学推理、代码生成及逻辑解谜等场景中展现卓越性能。模型支持高精度复杂推理,蒸馏版(R1-Distill)基于 Qwen 和 LLaMA 微调,兼顾轻量化与低成本部署,适配多样化算力需求。

DeepSeek-R1-Distll-Qwen-1.5B和7B模型通过多阶段知识蒸馏技术,将千亿级大模型的复杂推理能力压缩至轻量级架构,实现高性能与低成本的完美平衡。其核心技术包括:

1. 分层蒸馏策略

· 逻辑蒸馏:从教师模型中提取数学推理、代码生成的逻辑链,通过对比学习强化学生模型的思维链生成能力;

· 语义蒸馏:基于 KL 散度对齐师生模型的语义空间,保留对长文本、多义词的精准理解。

2. 动态量化自适应

· 采用混合精度(FP16/INT8)动态量化,在推理时根据任务复杂度自动切换计算模式。

· 通过蒸馏感知量化技术,缓解传统量化导致的精度损失,数学解题准确率保持教师模型的90%左右。

GitHub官方蒸馏模型评估情况:

3. Deepseek-R1模型部署方案

RK3588为4核Cortex-A76@2.4GHz + 4核Cortex-A55@1.8GHz + 6TOPS算力NPU处理器,它们在能源电力、工业控制、瑕疵检测、物体识别、智慧医疗等领域有着广泛应用。

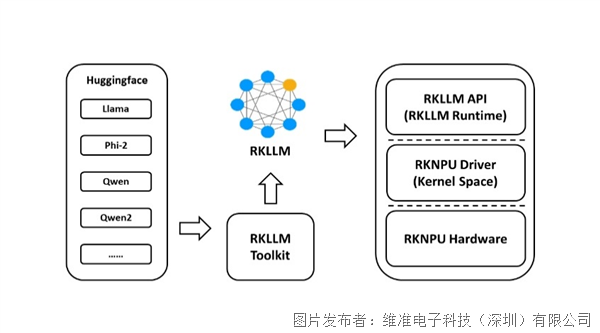

RKLLM-Toolkit是瑞芯微(Rockchip)推出的 AI 模型转换工具链,专为端侧设备优化设计,支持将主流大语言模型(如 LLaMA、DeepSeek-R1)高效迁移至 RK3588/RK3576 等芯片平台。

其核心技术包括:

· 跨框架量化压缩:支持 PyTorch/TensorFlow 模型转换为 INT8/INT4 量化格式,进行模型体积压缩,推理速度显著提升;

· 异构计算优化:RKNPU专为神经网络结构设计,自动拆分模型至 NPU+CPU 多核协同计算,动态调度算力资源,能效比提升;

RKLLM-Runtime 负责模型推理,将从RKLLM-Toolkit转换得到的.rkllm模型在RK3588本地通过调用NPU驱动,加速并进行模型的推理。

目前有两种DeepSeek-R1部署方案,分别是“RKLLM量化部署”和“Ollama部署”。

由于Ollama部署相比于RKLLM部署性能较弱,只能使用到CPU算力,芯片利用率较低,为了将RK3588强悍的NPU性能发挥出来,推荐使用“RKLLM量化部署”方案。

RKLLM量化部署:使用瑞芯微官方的RKLLM Toolkit工具进行量化部署,模型运行于NPU,适用于RK3588等带有NPU处理器的平台。

Ollama工具部署:Ollama是一个开源的大模型服务工具,使用CPU运行,适用于不带有NPU的通用处理器平台。

4. RKLLM模型部署

RKLLM软体架构

RKLLM部署流程

(1) 环境准备

操作系统:确保RK3588开发板运行的是支持ARM64架构的Linux系统(如Ubuntu或Debian)。

依赖工具:安装必要的工具链和依赖库,例如Python、Git、CMake等。

硬件要求:RK3588开发板需具备足够的计算资源(CPU、GPU/NPU)和内存(建议至少4GB RAM)。

(2) 获取蒸馏模型Deepseek-R1-Distill-1.5B

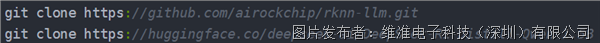

下载rknn-llm 和 deepseek模型

(3) RKLLM Toolkit/Runtime工具安装

在 RKLLM-Toolkit Conda 环境下使用 pip 工具直接安装所提供的工具链 whl 包,在安装过程中,安装工具会自动下载 RKLLM-Toolkit 工具所需要的相关依赖包。

#pip3 install rkllm_toolkit-1.1.4-cp38-cp38-linux_x86_64.whl

(4) 编写.py转换脚本进行模型转换

修改export_rkllm.py文件中的模型的存放路径和NPU核心数量,再执行如下命令运行export_rkllm.py文件将模型导出,使用RKLLM-Toolkit工具将Hugging Face模型转换为适配瑞芯微NPU的.rkllm格式。

#python export_rkllm.py

(5) 程序交叉编译

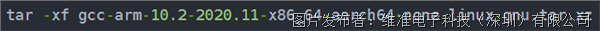

下载编译工具并解压缩

编译工具下载链接:https://developer.arm.com/downloads/-/gnu-a

修改编译脚本指定交叉编译工具的存放路径

执行build-linux.sh进行编译

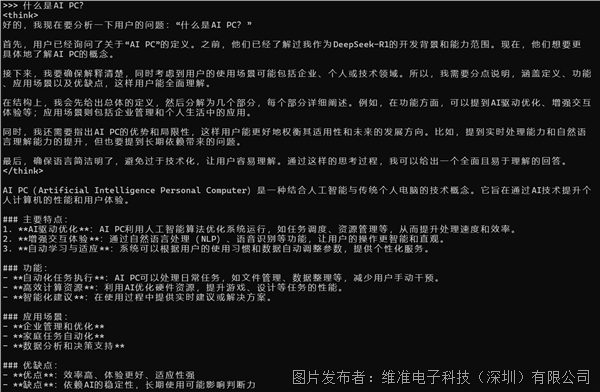

(6)运行展示

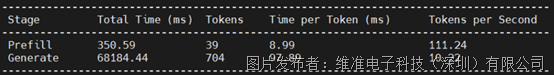

RKLLM推理性能:Token 10.22/s